付録A. データの不合理な有効性について:なぜデータが多ければ多いほど良いのか? より良いのか?

注

この付録は、筆者のブログの同名の記事から(若干の修正と訂正を加えて)転載したものである。

論文 "The unreasonable effectiveness of data "の中で、ハレヴィ、ノルヴィグ、ペレリラは、データの有効性を論じている。1GoogleのHalevy、Norvig、Pereriraは、コーパスがウェブ規模になると面白いことが起こると主張している:

単純なモデルと多くのデータは、少ないデータに基づくより精巧なモデルに勝る。

この論文と、ノービグが行ったより詳細な技術講演の中で、彼らは、コーパスが数億から数兆の学習サンプルや単語になると、基本的な独立性の仮定を持つ非常に単純なモデルが、より少ないデータで、注意深く作成されたオントロジーに基づくモデルなど、より複雑なモデルを上回ることができることを示している。しかし、なぜ データが多い方が良いのかについては、ほとんど説明されていない 。この付録では、その点について考えてみたい。

私は、より多くのデータがあった方が良い理由と問題にはいくつかの分類があることを提案する。

最近傍問題

最初の は最近傍タイプの問題である。Halevyらはその例を挙げている:

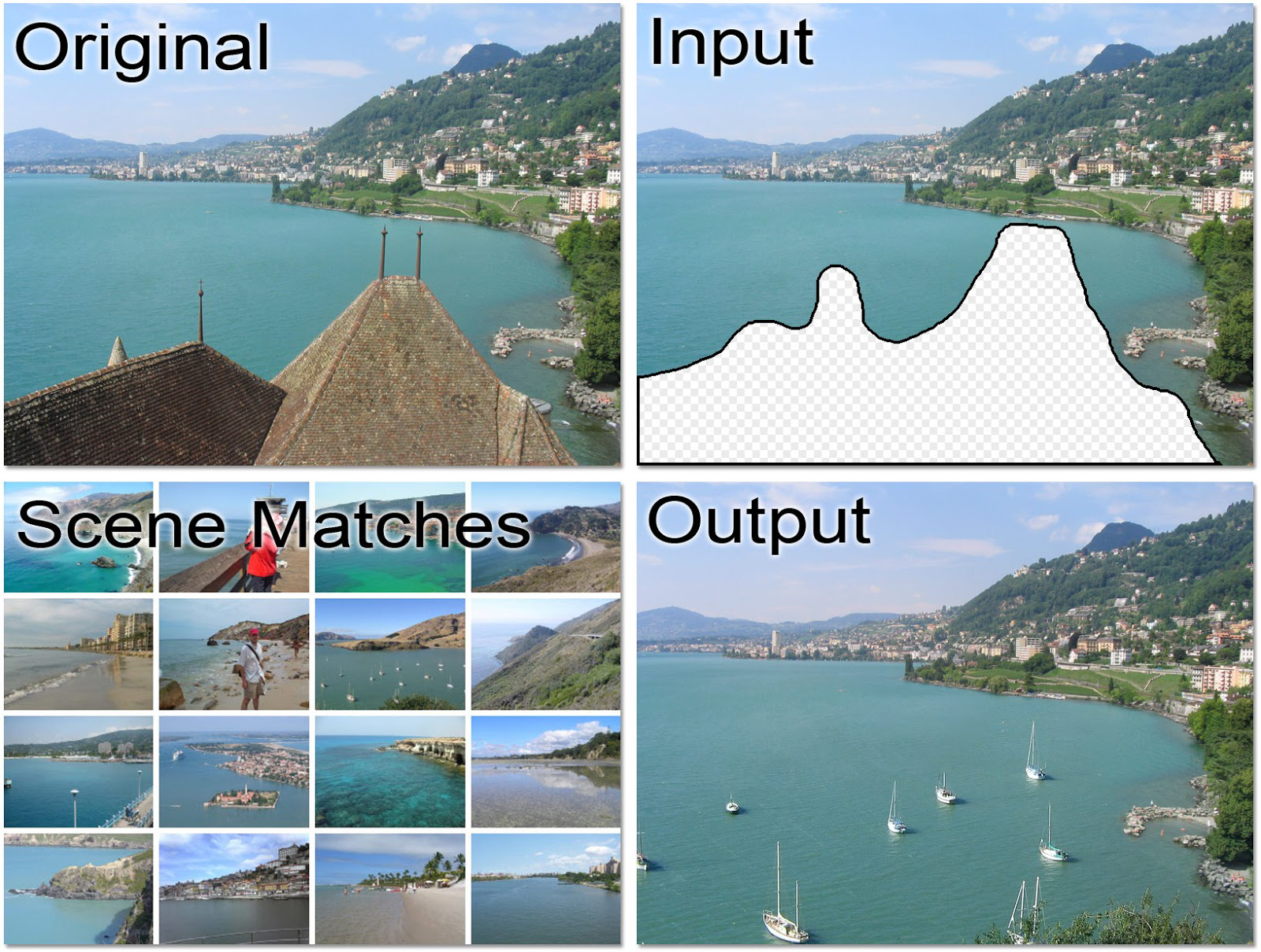

James HaysとAlexei A. Efrosは、シーン補完の課題に取り組んだ。写真から不要な、見苦しい自動車や元配偶者を取り除き、他の写真の大規模なコーパスから取得したピクセルで背景を埋める。2

図A-1. Hayes and Efros (2007)の図1.

ノルヴィグは次のような概略図を示した:

そして、結果が本当に悪いものから本当に良いものへと変化する「データのしきい値」と表現した。

私は、閾値や相転移に似たものがあるとは確信していない。これは、最も近い一致を発見するという問題のように思える。データが多ければ多いほど、より近い一致が期待できる。

HaysとEfros(2007)はこう述べている:

実際、1万枚の画像のデータセットに対するgist記述子の初期実験では、非常に落胆した。しかし、画像コレクションを200万枚に増やすと、性能は質的に飛躍した。独立して、Torralbaら[2007]は、最大7,000万枚の小さな(32x32)画像のデータセットで同様の効果を観測している...我々の手法が成功するには、大規模なデータセットが必要である。我々は、1万枚から200万枚の画像に移行したときに劇的な改善を見た。

これらのコーパスのサイズには大きな違いがあり、「質的な飛躍」は閾値(感覚的には相転移)とは違う。

より多くのデータは、単純な効果からメトリックに劇的な影響を与えることができる。インスタンスンス 標準正規からサイズnの標本を考える。その標本の最小値はnによってどのように変わるだろうか?異なるサイズの標本を作成し、次のRコードを使って最小値をプロットしてみよう:

x<-seq(1,7,0.5) y<-vector(mode="numeric",length=length(x)) ...