强化学习

|

525

注意,可能根本没有任何正奖励。例如,智能体可能在迷宫中四处走动,在每个步骤中

都获得负奖励,因此最好尽快找到出口!强化学习还有许多其他适合的任务,例如自动

驾驶汽车、推荐系统、在网页上放置广告或控制图像分类系统应集中注意力的地方。

18.2 策略搜索

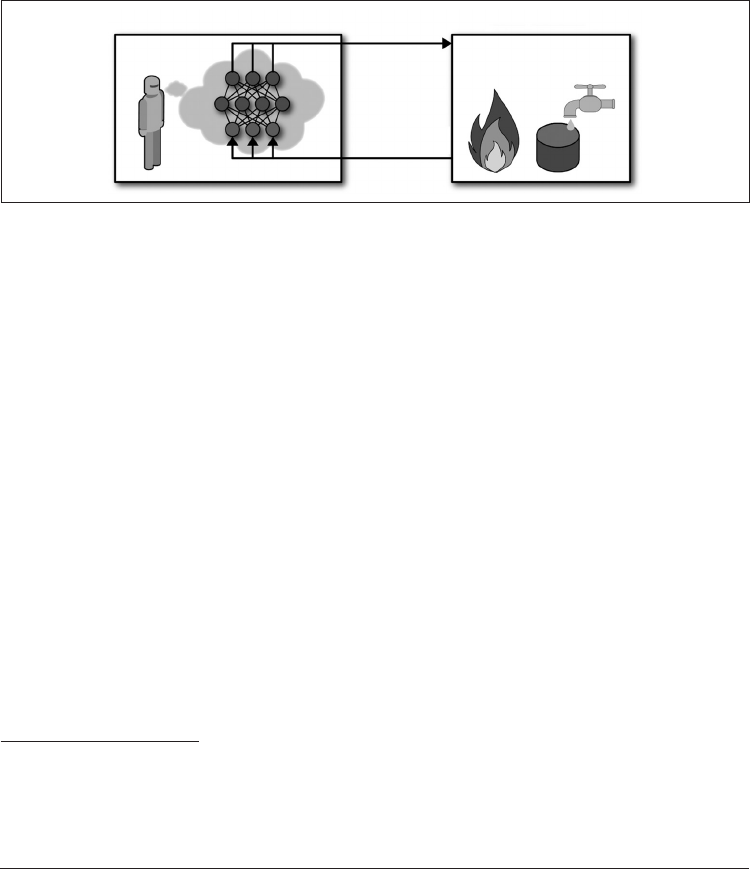

软件智能体用来确定其动作的算法称为其策略。该策略可以是一个神经网络,将观察作

为输入并输出要采取的行动(见图 18-2)。

智能体 环境

策略

奖励和观察

动作

图 18-2:使用神经网络策略进行强化学习

该策略可能是你能想到的任何算法,并且不必具有确定性。实际上,在某些情况下,甚

至不需要观察环境!例如,考虑一个机器人吸尘器,其奖励是在 30 分钟内吸走的灰尘

量。它的策略可能是以每秒概率

p

向前移动,或以概率 1

-

p

随机向左或向右旋转。旋转

角将是

-

r

和 +

r

之间的随机角度。由于此策略涉及某种随机性,因此称为随机策略。机

器人具有不确定的轨迹,这保证了它最终将到达任何位置并拾起所有灰尘。问题是,在

30 分钟内会吸走多少灰尘?

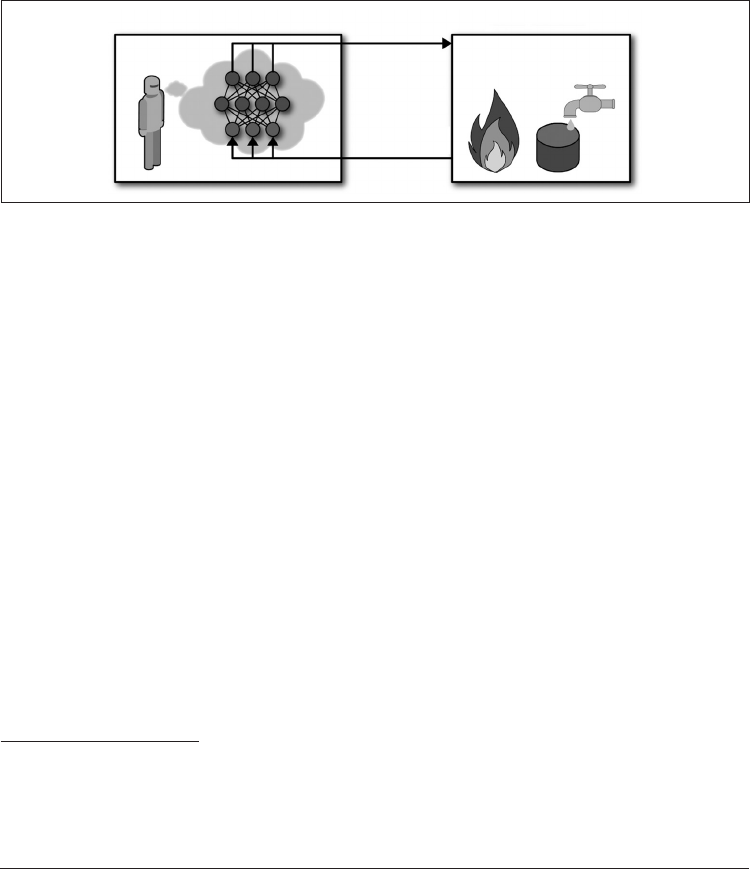

你将如何训练这样的机器人?你可以调整两个策略参数:概率

p

和角度范围

r

。一种

可能的学习算法可能是为这些参数尝试许多不同的值,然后选择效果最佳的组合(见

图 18-3)。这是策略搜索的示例,在这种情况下使用暴力解决方法。当策略空间太大时

(通常是这种情况),以这种方式查找一组好的参数就像大海捞针一样。

探索策略空间的另一种方法是使用遗传算法。例如,你可以随机创建第一代 100 条策略

并进行尝试,然后“杀死”80 条最差的策略