降维

|

209

是在高维空间中可视化实例的聚类(例如,以 2D 可视化 MNIST 图 像 )。

线性判别分析(

LDA

)

LDA 是一种分类算法,但是在训练过程中,它会学习各类之间最有判别力的轴,然

后可以使用这些轴来定义要在其上投影数据的超平面。这种方法的好处是投影将使

类保持尽可能远的距离,因此 LDA 是在运行其他分类算法(例如 SVM 分类器)之

前降低维度的好技术。

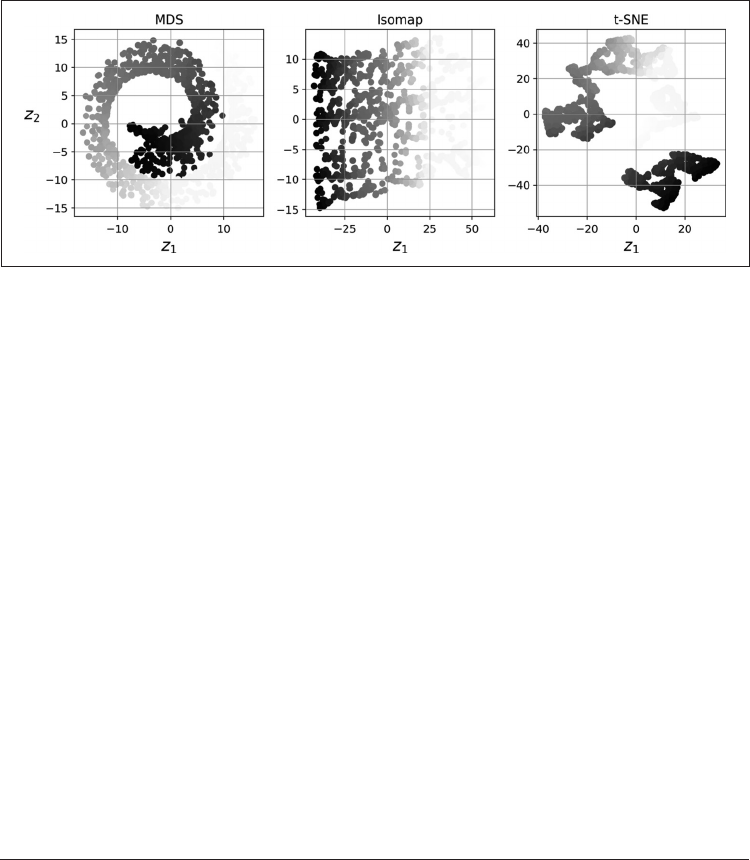

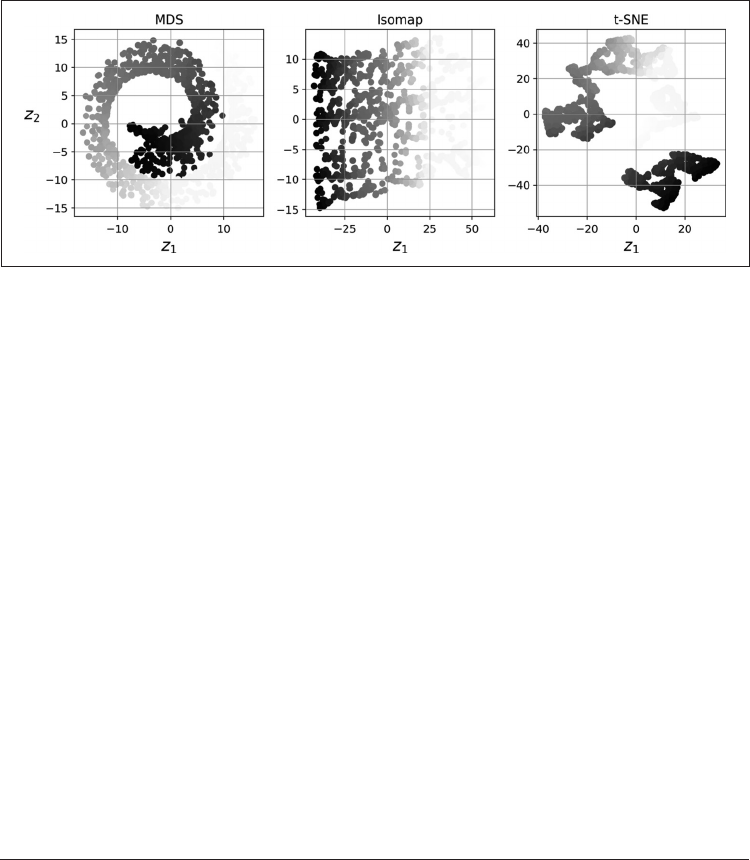

图 8-13 显示了其中一些技术的结果。

图 8-13:使用各种技术将瑞士卷降至 2D

8.7 练习题

1. 减少数据集维度的主要动机是什么?主要缺点是什么?

2. 维度的诅咒是什么?

3. 一旦降低了数据集的维度,是否可以逆操作?如果可以,怎么做?如果不能,为

什么?

4. 可以使用 PCA 来减少高度非线性的数据集的维度吗?

5. 假设你在 1000 维的数据集上执行 PCA,将可解释方差比设置为 95%。结果数据集

将具有多少个维度?

6. 在什么情况下,你将使用常规 PCA、增量 PCA、随机 PCA 或内核 PCA ?

7. 如何评估数据集中的降维算法的性能?

8. 链接两个不同的降维算法是否有意义?

9. 加载 MNIST 数据集(在第 3 章中介绍),并将其分为训练集和测试集(使用前 60 000

个实例进行训练,其余 10 000 个进行测试)。在数据集上训练随机森林分类器,花