Gradiente Descendente | 119

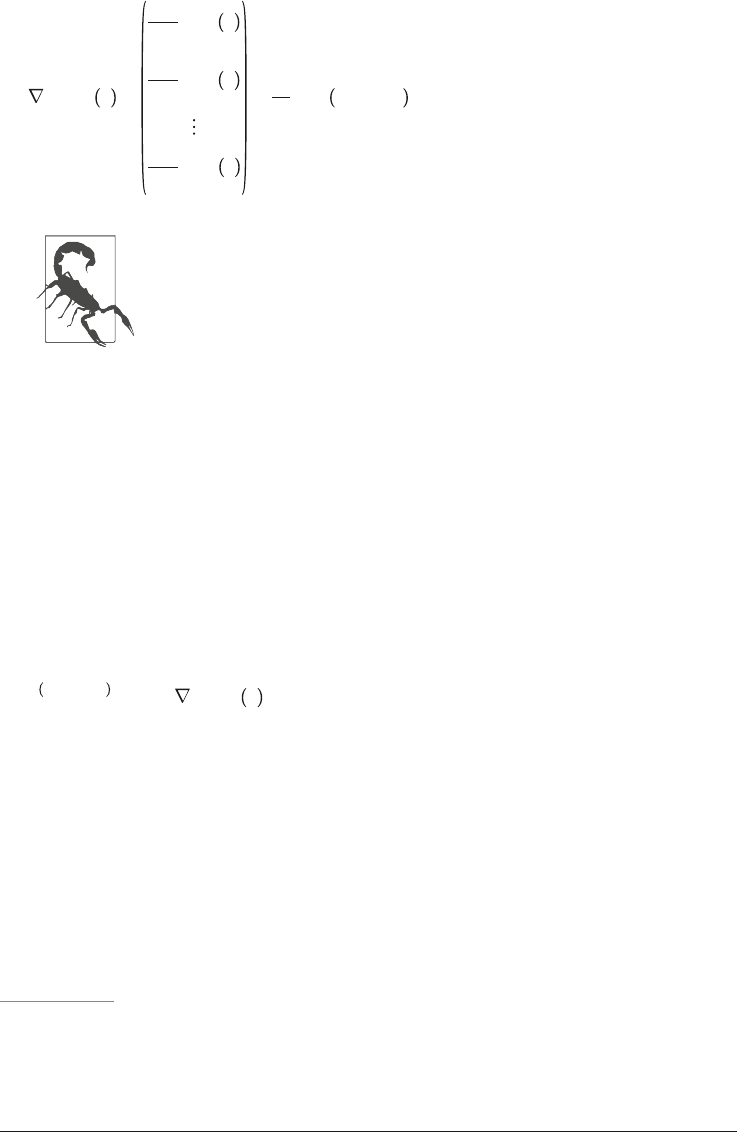

Equação 4-6. Vetor gradiente da função de custo

θ

MSE θ =

∂θ

0

MSE θ

∂

∂θ

1

MSE θ

∂

∂θ

MSE θ

=

2

m

X

T

· X · θ − y

Observe que esta fórmula envolve cálculos em cada etapa do Gra-

diente Descendente sobre o conjunto completo de treinamento X!

É por isso que o algoritmo é chamado de Gradiente Descendente em

Lote: ele utiliza todo o lote de dados em cada etapa. Como resultado,

ele é terrivelmente lento para grandes conjuntos (em breve veremos

algoritmos de gradiente descendente muito mais rápidos). No entan-

to, o Gradiente Descendente se dimensiona bem com a quantidade

de características; treinar um modelo de Regressão Linear, quando ...